Le chercheur américain John Ioannidis, professeur à Stanford, aime depuis quelques années lancer de bons gros pavés dans la mare de la science et en particulier dans celle de la biomédecine.

En 2005, dans un article publié par PLoS Medicine et intitulé "Pourquoi la plupart des découvertes publiées sont fausses", il montrait que les bases statistiques sur lesquelles s'appuyaient bon nombre d'études n'étaient pas suffisamment rigoureuses pour que les résultats obtenus aient une véritable valeur et que les biais étaient légion dans la conception d'essais cliniques censés décider de la mise sur le marché de médicaments. Ce sans oublier les intérêts financiers qui faisaient pression pour l'obtention de résultats. Depuis 2005, ce texte, devenu un classique, a été consulté près de 1,2 million de fois en ligne, un record. Aujourd'hui, John Ioannidis va plus loin, en signant un article acide publié le 21 octobre par PLoS Medicine, surmonté d'un autre titre provocateur ("Comment faire en sorte que plus d'études publiées soient vraies"...) où il met de nouveau les pieds dans le plat de la recherche scientifique.

On le comprend d'entrée de jeu, le but de John Ioannidis n'est pas de démolir la science ni ceux qui la font à grands coups de démonte-pneu. Son objectif consiste à améliorer le fonctionnement de la recherche car la marge de manœuvre, suggère-t-il, est grande. Dans l'énoncé du diagnostic, le chercheur américain, spécialiste de questions de santé, ne fait pas dans le diplomatique mais plutôt dans le direct. Il a recensé, entre 1996 et 2011, plus de 25 millions d'études scientifiques publiées, signées par quelque 15 millions de personnes de par le monde. Une quantité phénoménale d'articles, donc, à comparer avec un nombre de découvertes importantes beaucoup plus modeste.

Certes la science a pour règle de marcher lentement, presque de manière besogneuse, parce qu'il faut beaucoup de tours de chignole pour faire une percée et être sûr qu'on l'a bien réalisée. Mais John Ioannidis est convaincu depuis des années que le problème principal est ailleurs, qu'il est dû au fait que le système de recherche ne fonctionne plus correctement et que la plupart des "découvertes" qu'il engendre ou enregistre n'en sont pas : par la faute de protocoles inadaptés, de biais, de mauvais traitements statistiques voire de malhonnêteté intellectuelle, les résultats soi-disant significatifs sont trop souvent des faux positifs que l'on ne peut reproduire. Au bout du compte, en biomédecine, c'est jusqu'à 85 % des investissements faits dans les recherches qui sont perdus, soit un total annuel astronomique de 200 milliards de dollars ! Une autre estimation, moins précise, évoque un gâchis portant sur "des dizaines de milliards de dollars".

Or, selon l'auteur, le système fait peu pour se réformer, pour regagner en efficacité et donc en crédibilité auprès du public. John Ioannidis fait une description, en termes choisis mais qui contiennent souvent leur dose de vitriol, d'un monde académique parfois sclérosé où les personnes qui attribuent les budgets publics de recherche sont rarement de grands chercheurs, où le conservatisme le dispute au népotisme et au sexisme. Le paragraphe qu'il consacre au conflit d'intérêts vaut son pesant de cacahuètes : "Il arrive parfois que la même personne porte plusieurs chapeaux : un chercheur universitaire peut aussi diriger une revue, posséder une start-up, être membre d'une société savante, conseiller gouvernemental et/ou toucher de l'argent de l'industrie."

L'article n'aurait pas grand intérêt si John Ioannidis se contentait de critiquer. Mais le chercheur, qui co-dirige aussi depuis le printemps le Metrics (Meta-Research Innovation Center at Stanford), une institution travaillant justement sur l'amélioration des processus de recherche, est venu avec deux batteries de propositions. La première concerne la manière de mener des études et met l'accent sur le cheval de bataille de John Ioannidis : une plus grande collaboration entre les équipes pour obtenir des échantillons plus importants et des résultats sans équivoque ; inciter à la reproduction des travaux pour s'assurer que les effets mesurés sont réels, ce qui passe par une standardisation et un partage totalement transparent des protocoles, du matériel de recherche et des résultats. John Ioannidis insiste aussi sur un point sensible : la mise en place de critères plus stricts avant de crier à la victoire, à la découverte. Le but, écrit-il, est de réduire les faux positifs "dans les domaines qui ont jusqu'ici été trop accomodants (comme l'épidémiologie, la psychologie ou l'économie). Cela pourrait leur conférer une crédibilité plus importante, comparable à celle des secteurs qui ont traditionnellement été plus rigoureux de ce point de vue, comme les sciences physiques."

La seconde batterie de propositions est bien plus iconoclaste puisqu'elle touche non plus à la manière de faire des études mais à celle dont le petit monde de la recherche les "valorise". Sans jamais citer la fameuse formule "Publie ou péris", John Ioannidis explique que, dans le système scientifique, les articles publiés sont comme une monnaie : ils servent à obtenir des "biens" (un poste, un échelon hiérarchique). Cela n'est pas sans conséquence puisqu'on voit parfois certains chercheurs avoir une production prolifique de travaux médiocres voire non-reproductibles, en profiter pour monter dans les hiérarchies, entrer dans les revues, bénéficier de renvois d'ascenseur et obtenir leur signature dans une étude pour laquelle ils n'ont donné qu'un avis, etc. J'ai moi-même pu constater que certains adoptaient ce que John Ioannidis appelle (joliment) la technique du "salami", qui consiste à découper une recherche en tranches, en sous-sections, et à "vendre", sur la base d'une seule expérience, plusieurs études à des revues différentes...

A l'opposé, le système actuel ne récompense que mal ou pas du tout ceux qui veulent reproduire les expériences des autres pour vérifier leurs résultats ou ceux qui s'investissent à fond dans la relecture des articles des confrères. Seule l'étude publiée importe. John Ioannidis propose donc de modifier la manière dont la bibliométrie est prise en compte dans l'évaluation des chercheurs, de ne pas donner de valeur aux publications per se mais d'en accorder à celles qui ont été confirmées ou à celles qui ont "marché" parce qu'elles se sont transformées, dans le domaine de la biomédecine par exemple, en traitement efficace, en test de diagnostic fiable, etc. De la même manière, le travail de peer review, travail de l'ombre très chronophage si on veut le faire correctement, doit être récompensé. A l'inverse, une étude dont les résultats n'ont pas été reproduits ferait perdre des points avec le barème de John Ioannidis. Celui-ci va même beaucoup plus loin en suggérant que l'obtention de titres ou de postes prestigieux doit automatiquement s'accompagner d'un handicap en points si l'apport du chercheur à la science n'est pas proportionnel aux pouvoirs ou aux fonds qui lui ont été attribués. On se dit d'ailleurs, à voir la carte de visite de John Ioannidis, que ce dernier partirait avec un gros handicap...

Le chercheur américain a conscience que son scénario est "délibérément provocateur" et qu'il risquerait par exemple de décourager les ambitions de ceux qui veulent diriger un laboratoire. Néanmoins, l'article a le mérite de pointer les détails qui font mal, notamment le gâchis en temps et en argent que représentent toutes ces études dont les résultats ne se retrouvent jamais. A fréquenter chercheuses et chercheurs depuis presque dix-huit ans, j'ai entendu ici ou là, souvent sur le ton de la confidence, la plupart de ces critiques. Il y a quelque chose de sain et de salutaire à les voir, sans tabou, rassemblées sur la place publique.

Politique

Affaire Le Pen, inéligibilité et exécution provisoire : ce que dit vraiment le droit

Le Tribunal correctionnel de Paris a reconnu Marine Le Pen coupable de détournement de fonds publics ce lundi 31 mars, dans le cadre du procès des assistants p…

Économie

Transport aérien inter-îles dans les Caraïbes : Air Caraïbes et Air Antilles épinglés par l’Autorité de la concurrence

Les deux compagnies aériennes ont écopé de 14,5 millions d’euros de sanctions pour entente illégale. Accusées de s’être accordées sur les prix de leurs li…

Société

Airbag Takata : de qui se moquent les constructeurs ?

La recherche du moins disant, les petites économies d'un jour. Tout se paye un jour. Le rappel des airbags chez Citroën prend de l'ampleur et a de quoi inquié…

Europe

Accord UE-Mercosur : signature imminente ou nouvel épisode d’une interminable saga ?

Dans un contexte marqué par les négociations autour de l'accord commercial entre l'Europe et le Mercosur, le G20 s'ouvre ce lundi 18 novembre à Rio. Alors que…

Monde

Où en est l’accord de trêve entre Israël et le Hamas ?

Le 2 mars 2025, alors que devait démarrer la deuxième phase de l’accord du 15 janvier 2025 entre Israël et le Hamas, pour un cessez-le-feu à Gaza et la libérat…

Santé-Environnement

Matinale : sur les toits du monde

Les éléphants sont présents dans sa vie depuis son plus jeune âge et créer le “Voyage en soi sur la terre des éléphants”, est devenu une évidence. C'est comme…

Culture

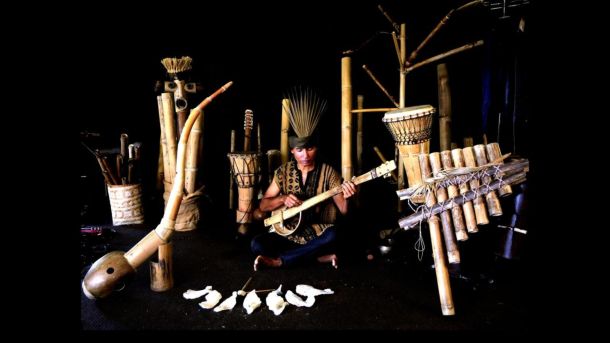

Le bambou : révolution philosophique, poétique et musicale

Et si la clé pour réenchanter le monde était secrètement gardé dans cette plante que certains surnomment l’herbe miraculeuse ? Vous ne le savez peut-être pas…

Sports

Équipe olympique des réfugiés : un flambeau « d’espoir et de paix »

37 athlètes réfugiés ont participé aux Jeux olympiques de Paris 2024. Il s’agit de la plus grande équipe depuis la création des équipes de réfugiés du Comité i…

People

A Lyon, Taylor Swift a mis les fans en ébullition

Présentes dans la nuit de samedi à dimanche et présentes en très grand nombre ce dimanche matin, les Swifities s'apprêtent à fouler la pelouse du Groupama Stad…

Catégories d'articles

BREAKING NEWS